どうも、stakのあつきです。

stakでは現在、企業向けにAI活用研修を行っており、現場でさまざまなご質問をいただきます。

その中でも、圧倒的に人気No.1の質問が「セキュリティ」についてです。

今日はこのテーマについて、これだけ見ればOKないように、わかりやすく重要な点だけをまとめます。

AIセキュリティの基本構造を知る

まず、ChatGPTをはじめとする生成AIは、クラウド上で動いています。

つまり、あなたが入力した情報は一度、OpenAI(アメリカの会社)のサーバーに送られて処理される仕組みです。

ここでよくある誤解が、「入力した情報 = 自動的にAIが学習する」というもの。

実際にはそうではありません。

ChatGPTでは、学習に使うかどうかは“自分で設定”できます。

しかも無料プランでも可能です。

設定画面を開いて、

💡「設定 → データコントロール → すべての人のためにモデルを改善する」

このチェックをオフにすればOKです。

これで、あなたが入力した内容がAIの学習に使われることは一切なくなります。

データはどこに行くのか?

入力したデータそのものは、OpenAIのサーバー上に一時的に保存されます。

期間は最大30日間で、その後は自動削除。

さらに通信は暗号化されているため、外部から盗み見られるリスクは非常に低いです。

これはGmailやSlackなど、一般的なクラウドサービスと同じレベルのセキュリティです。

つまり、AIだけが特別危険というわけではありません。

「Gmailは使うのにChatGPTは怖い」というのは、ある意味ナンセンスです。

企業でAIを使うときに本当に注意すべきこと

とはいえ、何でもかんでも好き勝手に使っているとリスクも生じます。

例えば、アカウント情報が漏れてしまった場合、過去の入力履歴すべてが第三者に見られてしまう可能性があります。

特に、同じパスワードを複数サービスで使っていたりすると、それだけで“全開放”状態になることも。

だからこそ、AIを安全に使うには「使い方のルール」が必要なんです。

ここを押さえておけば、セキュリティリスクは極限まで下げることができます。

▼ 注意すべき3つのポイント

1)機密情報は絶対に入力しない

顧客名・住所・社内の財務データなどはNG

どうしても例として入れたい場合は、“実在しない名前・数値・商品名”を仮で使う

2)個人アカウントでの業務利用は避ける

無料アカウントではなく、ChatGPT TeamやEnterpriseのような法人プランを使うことでデータが社内で隔離できる

3)アカウント管理と2段階認証の徹底

意外と多いのが「アカウント乗っ取り」

2段階認証を設定していなかったばかりに、外部からアクセスされるケースもある

※ セキュリティはAIの設定よりもまず人の設定だと思ってください。

「学習される」ってどういう意味?

AIが学習するというのは、入力内容をそのまま記憶しているわけではなく、入力データから“傾向や構造”を抽出してモデルを改善するということです。

たとえばあなたが「広島のおすすめカフェを教えて」と入力しても、“広島”や“カフェ”という単語が統計的にモデルの中に反映されるだけで、「あなたが広島にいる」まではAIは理解していません。

過去には一部の古いモデル(GPT-2など)で、学習データを推測できた例もありますが、現在のChatGPTやClaudeではそのようなリスクはほぼ排除されています。

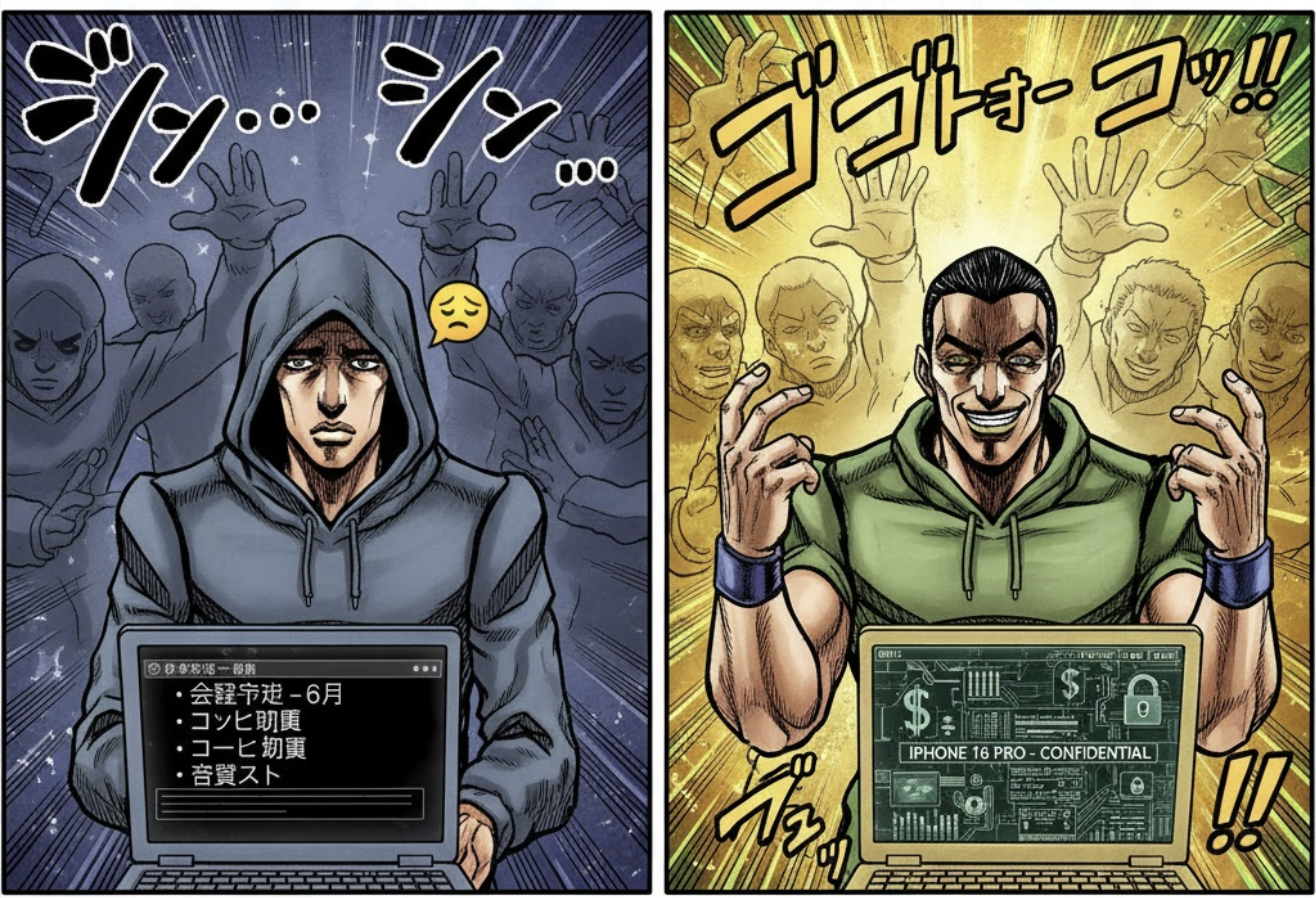

あなたの情報、実はそんなに“価値”ない説

ここで少し、あつき流の冗談を交えて話します。

「自分の情報がAIに取られたらどうしよう!」という声、よく聞きます。でも冷静に考えてください。

あなたの会社の「来月の会議予定」や「営業リスト」を見て、“ぜひこの情報がほしい!”って思う企業、どれだけいますか?

Appleの開発チームが次回のiPhone発表資料をAIに入力してたら、そりゃ世界中のハッカーが狙うでしょう。

でも、普通の中小企業の打ち合わせメモなんて、誰も積極的に欲しがりません。

「あなたの情報を欲しがってる人は、あなたが思うよりずっと少ない」です。

だからこそ、怖がるより“正しく理解して安全に使う”ことが重要なんです。

社内ガイドラインの作り方

では最後に、企業でAIを安全に活用するためのガイドライン例を紹介します。

“禁止ルール”というより、“これをやれば安心”という使える指針としてまとめました。

▼ 社内ガイドライン3ステップ

1)入力禁止項目の明確化

顧客情報、財務データ、未公開の戦略資料などは禁止項目として明文化

それでも実務で例を出す必要があるときは、「架空の顧客名・仮の金額・実在しない会社名」を使い

2)利用ツールの統一

「誰が何を使っているかわからない」が最も危険

ChatGPT TeamやGemini for Workspaceなど、社内で許可したツールだけを利用

管理部門が一括で設定を確認できるようにしておきましょう

3)教育と定期レビュー

半年に1回、社員全員が「すべての人のためにモデルを改善する」がオフになっているかを確認

同時に、活用事例の共有会を開くと“安全 × 生産性”の文化が定着しますね!

まとめ

・AIは危険ではなく、「知らないで使うこと」が危険

・学習設定をオフにし、個人情報は入力しない

・無料ツールを業務で使うのは避け、法人向けの環境を利用する

・ルールを作るときは「禁止よりも運用」を重視

・あなたの情報を狙っている人なんて、多くありません

つまり、AIは“怖いから避けるもの”ではなく、“理解して使うもの”です。

AIを拒む企業ほど、変化に取り残される時代。

リスクを正しく理解して活用する企業こそ、これからの主役になります。

株式会社stakでは、AIの安全な導入から、社員向けの研修・運用ガイドライン設計まで幅広く支援しています。

「AIを使いたいけど、社内ルールの作り方がわからない」という方は、ぜひお気軽にご相談ください。

▼ お問い合わせはこちらから